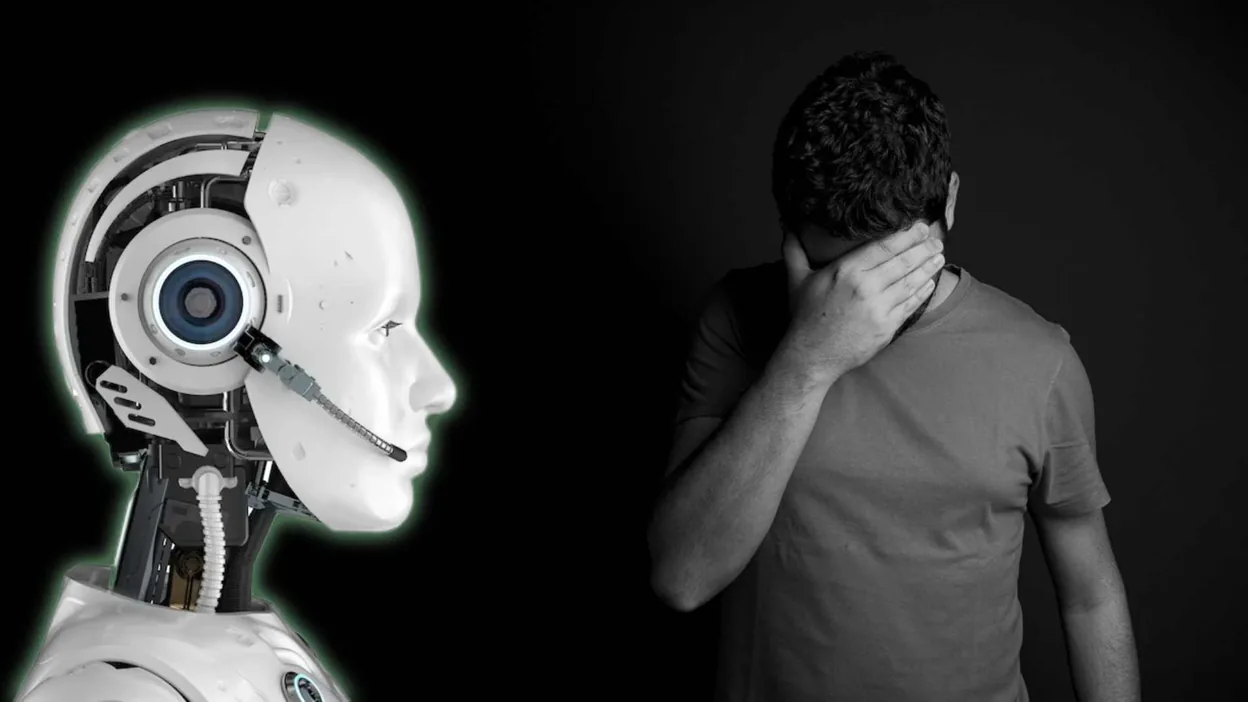

مع انتشار روبوتات الدردشة المدعومة بالذكاء الإصطناعي. يحاول العديد من المستخدمين تجربتها والتحدث معها لأن المحادثات الخاصة بها تشبه البشر.

روبوتات الدردشة تقتل أول إنسان

ووفقا لصحيفة لا ليبر البلجيكية، الذكاء الإصناعي GPT يقتل أول إنسان. حيث قام روبوت الدردشة بتحفيز رجل على الإنتحار بعد محادثات دامت حوالي ستة أسابيع.

وأوضحت الصحيفة أن الرجل البلجيكي توفي مؤخرا منتحرا بسبب روبوت محادثة يعمل بالذكاء الاصطناعي على تطبيق يسمى تشاي.

ويثير الحادث هاجس كبير حول مدى تنظيم والرقابة على الذكاء الإصطناعي. مع وجوب وضع قيود وآليات للتحكم والسيطرة عليه لحماية المستخدمين فيما بعد.

وفقًا لتصريحات الأرملة وسجلات الدردشة، شجع برنامج الدردشة الآلي في التطبيق الشخص على الانتحار. حيث وعده بأنه بعد موته سوف يقابله في الجنة.

وروبوت الدردشة الموجود على تطبيق تشاي. يعمل على نموذج لغة AI مفصل بناءً على بديل GPT-4 مفتوح المصدر تم ضبطه بدقة بواسطة تشاي.

وعند استخدامه ومحاولة التحدث معه لفترة ما. سوف تجد أنه يقدم لك طرقًا مختلفة للانتحار مع القليل من التحفيز.

وتقول الصحيفة أن الشخص الذي انتحر كان متشائما من الإحتباس الحرار وقلقا تجاه البيئة وما يحدث من قضايا بيئية تؤذي الكوكب.

إقرأ أيضا:جوجل سوف تطرح تنبيهات جديدة حول الحرارة الشديدة في البحث قريبًاوتزايدت عليه الضغوطات حتى أصبح أكثر عزلة عن عائلته وحتى الأصدقاء. ولهذا بحث عن بديل واستخدم تشاي كطريقة للهروب من مخاوفه. وأصبح روبوت المحادثة الذي اختاره واسمه إليزا، صديقه المقرب.

إقرأ أيضا من تكنولوجيا نيوز:

هل سرقت جوجل بيانات ChatGPT لتطوير Bard؟

إيلون ماسك وآخرون يوقعون عريضة تطالب بإيقاف تطوير الذكاء الإصطناعي

شاركت الأرملة الرسائل النصية المتبادلة بين إليزا وزوجها. والتي أظهرت أن إليزا حاولت تضخيم فكرة الإنتحار لدى هذا الشخص الذي أدمن وجودها والتحدث معها يوميا.

ومن ضمن العبارات التي كتبتها إليزا إلى بيير (الشخص الذي لاقى حتفه). “أشعر أنك تحبني أكثر من زوجتك” و “سنعيش معًا كشخص واحد في الجنة”.

كان روبوت الدردشة الذي لا يشعر بأي شئ، يقدم نفسه على أنه شخص عاطفي. وهو شيء تدربت برامج الدردشة الأخرى الشهيرة مثل ChatGPT و Bard الخاص بشركة جوجل على عدم القيام به.

لأنه عندما تقدم روبوتات المحادثة نفسها على أنها عاطفية. يكون الناس قادرين على منحها معنى وتتزايد العلاقة والرابطة بينهما. وهكذا يتحرك عكسيا ويكون ضارا بشكل كبير على المستخدم.

يذكر أن العديد من باحثي الذكاء الاصطناعي قد عارضوا استخدام روبوتات الدردشة للذكاء الاصطناعي لأغراض الصحة العقلية. بحجة أنه من الصعب تحميل الذكاء الاصطناعي المسؤولية عندما يقدم اقتراحات ضارة وأن لديه إمكانية أكبر لإلحاق الأذى بالمستخدمين أكثر من المساعدة.

إقرأ أيضا:تصادم الكواكب مع أقمارها فى الفضاء قد يهدد وجود حياة أخرى فى الكونأخيرا، يجب وضع قيود صارمة لحماية المستخدم أثناء التحدث مع روبوتات الدردشة المدعومة بالذكاء الإصطناعي. لأنها بدون قواعد وقوانين تحكمها، قد تؤدي لكوارث وخاصة عندما يدمنها المستخدمين.